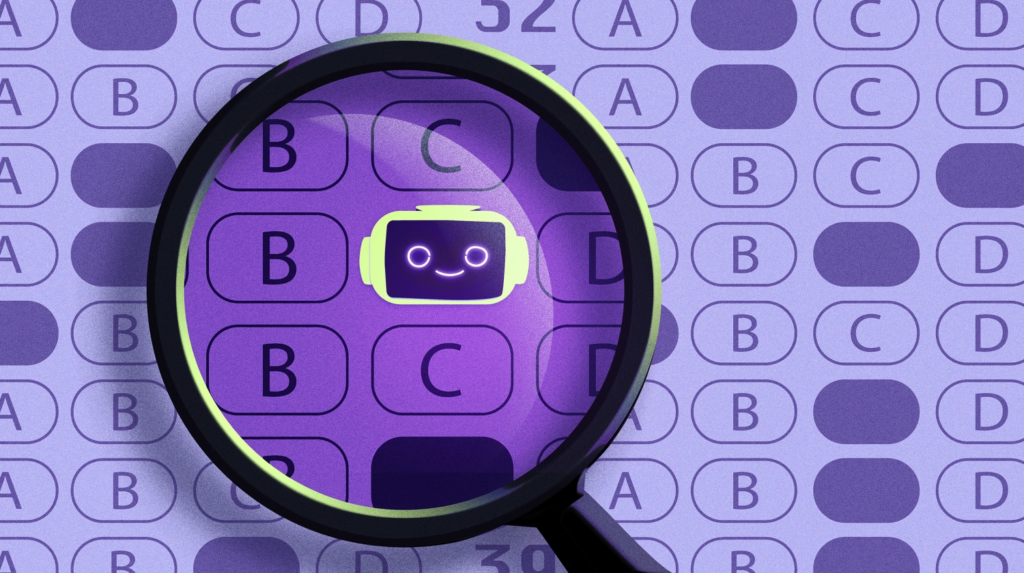

انتشار ChatGPT بين الطلاب يخيف المعلمين والخبراء.. يبحثون عن أدوات

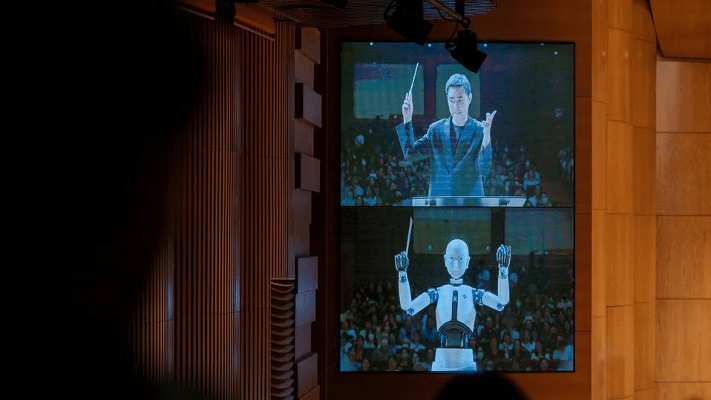

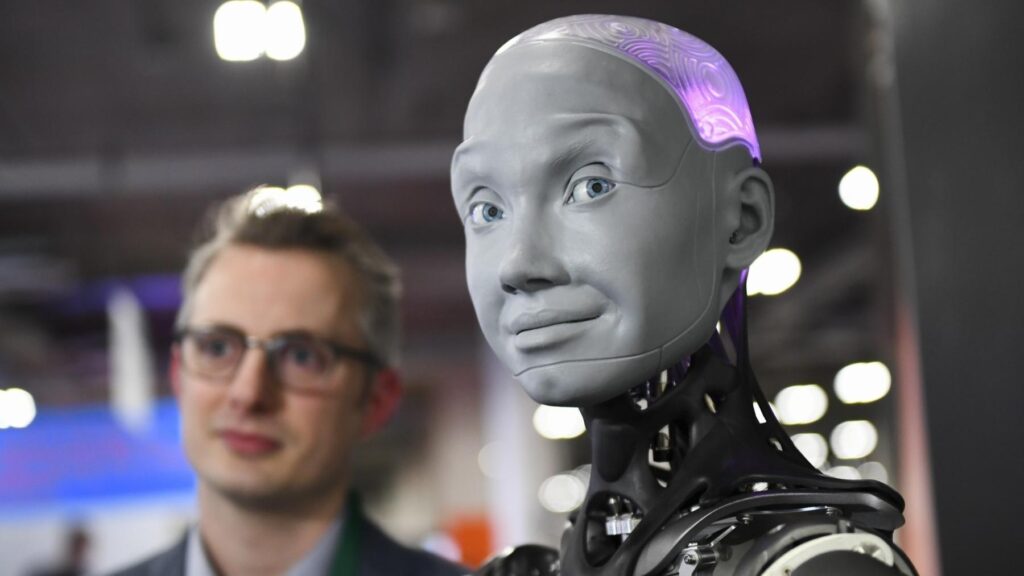

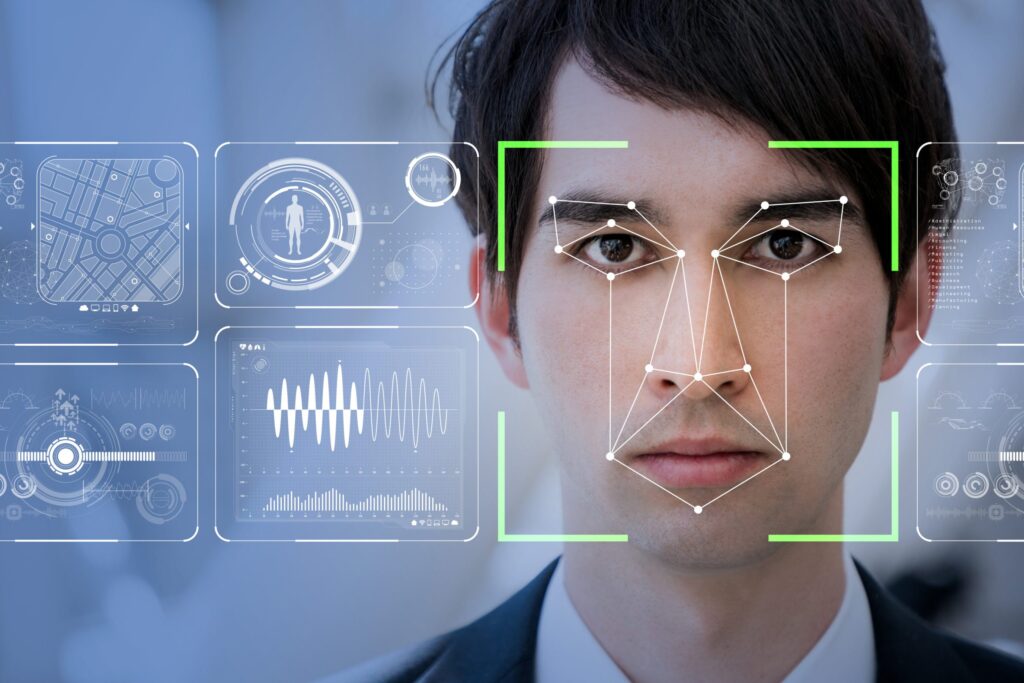

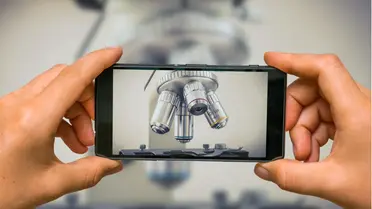

أدَّى ظهور أدوات الذكاء الاصطناعي القادرة على كتابة النصوص مثل تطبيق ChatGPT، إلى إنشاء طلب موازٍ

لفئة مستحدثة من الأنظمة التي يمكن أن تساعد في التمييز بين النصوص والصور التي أُنشئت بالذكاء

الاصطناعي وتلك التي أنشأها بشر، حسب ما ذكره موقع Axios الأمريكي، الأربعاء 1 فبراير/شباط 2023.

فقد اشتد الاهتمام بالأمر بين المعلمين خاصةً، لأنهم أحرص الناس على اضطلاع الطلاب بفروضهم المنزلية

واختباراتهم، وعدم اللجوء إلى أنظمة الذكاء الاصطناعي للتهرب منها.

أدوات الكشف لمواجهة الذكاء الاصطناعي

لكن الاهتمام لم يقتصر على المعلمين، فبعض الخبراء أبدوا تخوفهم أيضاً من فيض المعلومات المضللة ووسائل

انتحال الهوية التي يمكن أن تنشرها أدوات الذكاء الاصطناعي. ولذلك، فإنهم مهتمون بأدوات الكشف؛ على أمل

أن تساعدهم إذا أمكن جعلها دقيقة بما فيه الكفاية.

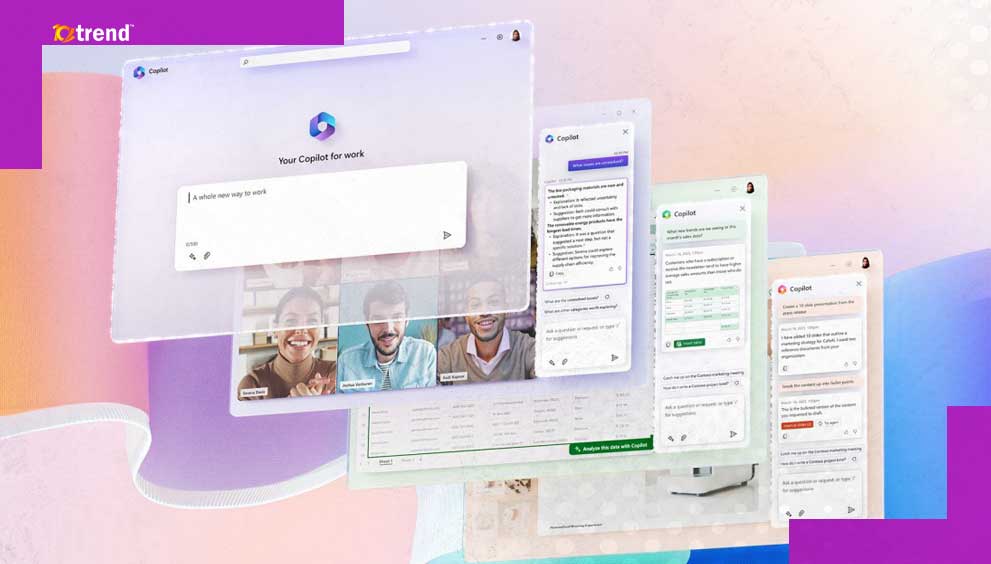

يأتي ذلك بعد أن أصدرت شركة OpenAI أداةً إلكترونية مجانية، الثلاثاء 31 يناير/كانون الثاني، للمساعدة في التمييز

بين النصوص المولَّدة بالذكاء الاصطناعي وتلك التي كتبها بشر.

مع ذلك، فإنها ليست الشركة الوحيدة التي تحاول معالجة هذه المشكلة، فقد بدأت عدة شركات ناشئة ومؤسسات

وأفراد في إصدار أو تطوير برامج للكشف عن النصوص والصور المولَّدة عن طريق الآلة.

في هذا السياق، أنشأ الطالب الجامعي إدوارد تيان تطبيقَ GPTZero، وهي أداة مشابهة للبرنامج الذي أصدرته

شركة OpenAI، وتُستخدم في تحليل أجزاء من النصوص والكشف عن نسبة توليدها آلياً بالذكاء الاصطناعي.

اختبرت شركة Fictitious.ai، الناشئة ذاتية التمويل، منتجاً آخر بالتعاون مع مؤسسات تعليمية، وتقوم هذه الأداة

على تحليل المحتوى فقرة بفقرة بدلاً من تقديم نتيجة إجمالية للنص. ولدى موقع Writer.com أداة لمساعدة الكُتَّاب

في فحص كتاباتهم، لأن محركات البحث تحظر المحتوى الذي تخلص إلى أنه مكتوب آلياً.

لكنها قد تكون غير كافية

لكن، وعلى الرغم من أن أدوات الكشف المستحدثة أظهرت قدراً من الأهمية، فإنها كشفت عن كونها معرضة لارتكاب

الأخطاء أيضاً، خاصة عند استخدامها في تحليل عينات تختلف اختلافاً كبيراً عن النصوص التي تدربت على تحليلها.

بناءً على ذلك، أشار خبراء إلى أن أدوات الكشف عن النصوص المولدة بالذكاء الاصطناعي ستتحسن بلا شك، لكن

أدوات التهرب منها ستتحسن أيضاً، ما يعني أن الأمر سيدور بين كرٍّ وفرٍّ.

بينما قال متحدث باسم Fictitious.ai لموقع Axios: “نرى أن تقنيات الرصد للمحتوى المولَّد بالذكاء الاصطناعي ستتحسن

وستمضي قدماً في تجاوز القدرة البشرية على التمييز بين المحتوى المكتوب آلياً ونظيره الذي كتبه بشر.

مع ذلك، فإنه من الواضح لنا أن تحرير البشر للنصوص يمكنه عند حدٍّ معين أن يحجب آثار المحتوى المولَّد بالذكاء الاصطناعي”.

في غضون ذلك، تبحث شركة OpenAI وغيرها عن أساليب أخرى، منها وضع علامات مائية على النصوص المولدة

بأدواتهم لتسهيل رصد المحتوى الذي أنشأته أدوات الذكاء الاصطناعي.

كل شيء عرضة للتشكيك

الخلاصة من ذلك أن المحتوى المولَّد بالذكاء الاصطناعي بلغ مستوى غير مسبوق في شعبيته، ما يعني أن جميع

أنواع المحتوى المولَّد إلكترونياً قد تصبح عرضة للتشكيك والفحص.

في حين أن التحدي القائم هو تطوير أنظمة كافية -بشرية وآلية- للتعامل مع المحتوى المتدفق وما قد يسببه من مشكلات

إضافية، في وقت تعدُّ فيه المعلومات المضللة مشكلة كبرى بالفعل.

من جهة أخرى، أجرى موقع Axios تجربة عملية عرض فيها “رسالة إخبارية” على أدوات كشف مختلفة لتحليلها،

وكانت النتائج كالآتي:

- OpenAI: “الأداة ترى أن هذا النص من المستبعد أن يكون مولَّداً بالذكاء الاصطناعي”.

- GPTZero: “الغالب أن نصك كتبه بشري، لكن فيه بعض الجمل المثيرة للشك”.

- Fictitious.AI: قسَّمت هذه الأداة محتوى الرسالة الإخبارية إلى فقرات.

- Writer.com: “رائع!” (ما يعني أنه نص كتبه بشر).