رحلة الذكاء الاصطناعي: من تقليد العقل البشري إلى هزيمة بطل العالم للشطرنج

“ذكاؤنا هو ما يجعلنا بشراً، والذكاء الاصطناعي هو امتداد لهذه الخاصية”، هكذا قال يان ليكون عالم الكمبيوتر البارز، ملخصاً تاريخ الذكاء الاصطناعي الذي يظهر أن محاكاة العقل البشري كانت الطريق الذي مكنه من الوصول إلى المستوى المذهل الذي بات عليه اليوم.

بدأ تاريخ الذكاء الاصطناعي مع اكتشاف أساسيات الطريقة التي يتم بها تجميع خلايا الدماغ البشري معاً في الأربعينيات من القرن العشرين، حيث بدأ علماء الكمبيوتر يتساءلون عما إذا كان من الممكن توصيل الآلات بالطريقة نفسها، حسبما ورد في تقرير لمجلة the Economist البريطانية.

ففي النصف الأول من القرن العشرين، عرّف الخيال العلمي العالم بمفهوم الروبوتات ذات الذكاء الاصطناعي.

تاريخ الذكاء الاصطناعي بدأ مع هذا العالم المؤمن بأن العلوم البينية هي التي تحمل الجديد

في عام 1934، كان عالم الرياضيات الأمريكي البروفيسور نوربرت وينر يعقد جلسات لـاثنين من الأكاديميين الآخرين لمناقشة الأبحاث المتعلقة بالعلوم البينية التي تقع على الحدود بين العلوم الرئيسية والتي كان مقتنعاً بأنها توفر الفرص الأكبر للاكتشافات الجديدة

وهذه مجالات دراسية لا تقع بشكل واضح ضمن تخصص معين ولكنها مزيج من التخصصات، مثل دراسة الطب والهندسة معاً لإنشاء مجال الهندسة الطبية.

من هذه الجلسات ومن أبحاثه الشخصية، تعلم وينر عن الأبحاث الجديدة حول الأجهزة العصبية البيولوجية بالإضافة إلى العمل الرائد في مجال أجهزة الكمبيوتر الإلكترونية.

وكان ميله الطبيعي هو المزج بين هذين المجالين، فتشكلت علاقة بين علم الأعصاب وعلوم الكمبيوتر. أصبحت هذه العلاقة حجر الزاوية في إنشاء الذكاء الاصطناعي كما نعرفه، حسبما ورد في تقرير لموقع Freecodecamp.

الفكرة هي بناء آلة تحاكي طريقة عمل المخ البشري

بحلول خمسينيات القرن العشرين، كان هناك جيل من العلماء والرياضيين والفلاسفة الذين استوعبوا مفهوم الذكاء الاصطناعي ثقافياً في أذهانهم.

كان أحد هؤلاء الأشخاص هو آلان تورينج، وهو عالم بريطاني شاب اكتشف الإمكانية الرياضية للذكاء الاصطناعي. اقترح تورينج أن البشر يستخدمون المعلومات المتاحة وكذلك العقل لحل المشكلات واتخاذ القرارات، فلماذا لا تستطيع الآلات أن تفعل الشيء نفسه؟ كان هذا هو الإطار المنطقي لبحثه الذي نشره عام 1950 تحت عنوان “آلات الحوسبة والذكاء”، والذي ناقش فيه كيفية بناء آلات ذكية وكيفية اختبار ذكائها، حسبما ورد في تقرير لموقع جامعة هارفارد الأمريكية.

لكن كان هناك عراقيل أمام تورينج لتنفيذ فكرته في ذلك الوقت. أولاً، تحتاج أجهزة الكمبيوتر إلى تغيير جذري. قبل عام 1949، كانت أجهزة الكمبيوتر تفتقر إلى شرط أساسي للذكاء: لم يكن بمقدورها تخزين الأوامر، بل تنفيذها فقط. بمعنى آخر، يمكن إخبار أجهزة الكمبيوتر بما يجب القيام به، لكنها لا تستطيع تذكر ما فعلته.

ثانياً، كانت الحوسبة باهظة الثمن للغاية.

وكانت هناك حاجة إلى إثبات المفهوم بالإضافة إلى الدعم من أشخاص بارزين لإقناع مصادر التمويل بأن الذكاء الآلي يستحق المتابعة.

تعرف على أول برنامج للذكاء الاصطناعي

بعد خمس سنوات، تمت إثبات المفهوم من خلال ألين نيويل، وكليف شو، وهيربرت سيمون، عبر برنامج The Logic Theorist (المنظر المنطقي) الذي كان مصمماً لتقليد مهارات حل المشكلات لدى الإنسان وتم تمويله من قبل مؤسسة البحث والتطوير (RAND).

يعتبره الكثيرون أول برنامج للذكاء الاصطناعي، وأثبت المنظر المنطقي 38 من أول 52 نظرية في الفصل الثاني من كتاب وايتهيد وبرتراند راسل مبادئ الرياضيات، ووجد أدلة جديدة وأقصر لبعضها

وقد تم تقديمه في مشروع دارتموث الصيفي لأبحاث الذكاء الاصطناعي (DSRPAI) الذي استضافه جون مكارثي ومارفين مينسكي في عام 1956.

في هذا المؤتمر التاريخي، تصور مكارثي جهداً تعاونياً كبيراً، يعمل فيه كبار الباحثين من مختلف المجالات لإجراء مناقشة مفتوحة حول الذكاء الاصطناعي، وهو المصطلح الذي صاغه مكارثي في نفس الحدث. ومن المؤسف أن المؤتمر لم يرق إلى مستوى توقعات مكارثي، حيث قوبل باستقبال فاتر.

كان هناك فشل في الاتفاق على الأساليب القياسية لهذا المجال. وعلى الرغم من ذلك، فقد وافق الجميع بكل إخلاص على الشعور بأن الذكاء الاصطناعي يمكن تحقيقه. لا يمكن التقليل من أهمية هذا الحدث لأنه حفز أبحاث الذكاء الاصطناعي على مدار العشرين عاماً القادمة.

كيف يحاكي الذكاء الاصطناعي المخ البشري؟

ويعرف الذكاء الاصطناعي أحياناً بأنه قدرة الآلة على التفكير والتصرف مثل الإنسان. ويتيح الذكاء الاصطناعي للكمبيوتر القيام بالعمل من خلال اتخاذ القرارات نيابةً عن الإنسان، حسبما ورد في تقرير لموقع جامعة Hull الأمريكية.

في الدماغ البيولوجي توجد اتصالات بين الخلايا العصبية التي تسمح للنشاط في إحداها بتحفيز أو قمع النشاط في أخرى. ما تفعله إحدى الخلايا العصبية يعتمد على ما تفعله الخلايا العصبية الأخرى المرتبطة بها، حسب تقرير The Economist.

واستخدمت المحاولة الأولى لنمذجة ذلك في المختبر بواسطة مارفن مينسكي أجهزة لنمذجة شبكات الخلايا العصبية. ومنذ ذلك الحين، تمت محاكاة طبقات من الخلايا العصبية المترابطة في البرمجيات.

هذه الشبكات العصبية الاصطناعية ليست مبرمجة باستخدام قواعد واضحة؛ وبدلاً من ذلك، فإنها “تتعلم من خلال التعرض للكثير من الأمثلة”.

خلال هذا التدريب، يتم تعديل قوة الاتصالات بين الخلايا العصبية (المعروفة باسم “الأوزان”) بشكل متكرر بحيث ينتج في النهاية مدخلات معينة مخرجات مناسبة. وقد تخلى مينسكي نفسه عن الفكرة، لكن آخرين دفعوها قدماً.

وتتضمن أبحاث الذكاء الاصطناعي الحديثة إنشاء وتنفيذ خوارزميات تهدف إلى محاكاة العمليات العصبية للدماغ البشري. هدفهم هو إنشاء أنظمة تتعلم وتتصرف بطرق مشابهة للبشر.

وفي الفترة من 1957 إلى 1974، ازدهر الذكاء الاصطناعي. يمكن لأجهزة الكمبيوتر تخزين المزيد من المعلومات وأصبحت أسرع وأرخص وأسهل في الوصول إليها. كما تحسنت خوارزميات التعلم الآلي وأصبح الأشخاص أفضل في معرفة الخوارزمية التي يجب تطبيقها على مشكلاتهم. أظهرت العروض التوضيحية المبكرة، مثل كتاب نيويل وسيمون لحل المشكلات العامة وإليزا لجوزيف وايزنباوم، نتائج واعدة نحو أهداف حل المشكلات وتفسير اللغة المنطوقة على التوالي.

هذه النجاحات، بالإضافة إلى تأييد كبار الباحثين، أقنعت الوكالات الحكومية مثل وكالة مشاريع الأبحاث الدفاعية المتقدمة (DARPA) بتمويل أبحاث الذكاء الاصطناعي في العديد من المؤسسات. كانت الحكومة مهتمة بشكل خاص بالآلات التي يمكنها نسخ وترجمة اللغة المنطوقة بالإضافة إلى معالجة البيانات عالية الإنتاجية. وكان التفاؤل عالياً والتوقعات أعلى.

كشفت هذه الأبحاث الأولية عن الذكاء الاصطناعي عن عقبات عديدة، وكان أكبرها هو الافتقار إلى القوة الحسابية اللازمة لفعل أي شيء جوهري: إذ لم تتمكن أجهزة الكمبيوتر ببساطة من تخزين ما يكفي من المعلومات أو معالجتها بالسرعة الكافية، حسب تقرير هارفارد.

من أجل التواصل، على سبيل المثال، يحتاج المرء إلى معرفة معاني العديد من الكلمات وفهمها في العديد من المجموعات. صرح هانز مورافيك، وهو طالب دكتوراه لدى مكارثي في ذلك الوقت، أن “أجهزة الكمبيوتر كانت لا تزال أضعف بملايين المرات من إظهار الذكاء”. ومع تضاؤل الصبر، تضاءل التمويل أيضاً، وأصبحت الأبحاث بطيئة لمدة عشر سنوات.

كان ثمانينيات القرن العشرين مرحلة مهمة في تاريخ الذكاء الاصطناعي، حيث عاد له الزخم من جديد بفِعل مصدرين: التوسع في مجموعة الأدوات الخوارزمية، وتعزيز التمويل.

وقام جون هوبفيلد وديفيد روميلهارت بنشر تقنيات “التعلم العميق” التي سمحت لأجهزة الكمبيوتر بالتعلم باستخدام التجارب. ومن ناحية أخرى، قدم إدوارد فايجنباوم الأنظمة الخبيرة التي تحاكي عملية اتخاذ القرار التي يقوم بها الخبير البشري.

سيسأل البرنامج أحد الخبراء في مجال ما عن كيفية الاستجابة في موقف معين، وبمجرد تعلم ذلك في كل موقف تقريباً، يمكن لغير الخبراء الحصول على المشورة من هذا البرنامج.

تم استخدام الأنظمة المتخصصة على نطاق واسع في الصناعات. وقامت الحكومة اليابانية بتمويل الأنظمة المتخصصة والمساعي الأخرى المتعلقة بالذكاء الاصطناعي بشكل كبير كجزء من مشروع كمبيوتر الجيل الخامس (FGCP). وفي الفترة من 1982 إلى 1990، استثمروا $400 مليون دولار بهدف إحداث ثورة في معالجة الكمبيوتر، وتنفيذ البرمجة المنطقية، وتحسين الذكاء الاصطناعي. ولسوء الحظ، لم يتم تحقيق معظم الأهداف الطموحة للبرنامج. ومع ذلك، يمكن القول إن التأثيرات غير المباشرة لبرنامج FGCP ألهمت جيلاً شاباً موهوباً من المهندسين والعلماء. ورغم ذلك توقف تمويل FGCP، وخرج الذكاء الاصطناعي من دائرة الضوء.

الذكاء الاصطناعي تقدم في ظل غياب التمويل الحكومي واهتمام الجمهور

ومن مفارقات تاريخ الذكاء الاصطناعي أنه في ظل غياب التمويل الحكومي والاهتمام العام، ازدهر الذكاء الاصطناعي.

وخلال التسعينيات والعقد الأول من القرن الحادي والعشرين، تم تحقيق العديد من الأهداف التاريخية للذكاء الاصطناعي.

ففي عام 1997، هُزم بطل العالم في الشطرنج والأستاذ الكبير غاري كاسباروف أمام برنامج Deep Blue من شركة IBM، وهو برنامج كمبيوتر خاص بلعب الشطرنج.

كانت هذه المباراة التي حظيت بتغطية إعلامية كبيرة هي المرة الأولى التي يخسر فيها بطل العالم في الشطرنج أمام جهاز كمبيوتر وكانت بمثابة خطوة كبيرة نحو برنامج صنع القرار بالذكاء الاصطناعي.

وفي نفس العام، تم تطبيق برنامج التعرف على الكلام، الذي طورته شركة Dragon Systems، على نظام Windows. وكانت هذه خطوة عظيمة أخرى إلى الأمام ولكن في اتجاه مسعى ترجمة اللغة المنطوقة.

وبدا أنه لا توجد مشكلة لا تستطيع الآلات التعامل معها. حتى مع المشاعر الإنسانية مثل Kismet، وهو روبوت طورته سينثيا بريزيل يمكنه التعرف على المشاعر وعرضها.

إضافة مزيد من طبقات الخلايا العصبية سمح بإنجازات أكثر تعقيداً

وتحقق كل ذلك بفضل تطور مهم، فبحلول أوائل التسعينيات، تم تدريب الشبكات العصبية على القيام بأشياء مثل المساعدة في فرز البريد من خلال التعرف على الأرقام المكتوبة بخط اليد.

ويعتقد الباحثون أن إضافة المزيد من طبقات الخلايا العصبية قد يسمح بإنجازات أكثر تعقيداً.

ولكنه أيضاً جعل الأنظمة تعمل بشكل أبطأ بكثير.

لقد وفرت أنواع جديدة من أجهزة الكمبيوتر طريقة للتغلب على المشكلة.

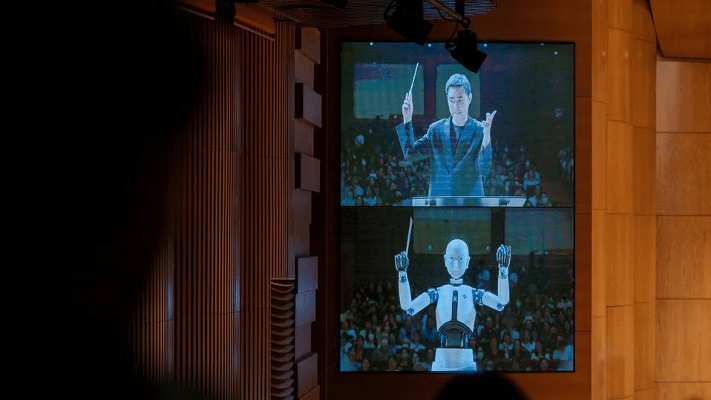

عرض توضيحي بشأن الذكاء الاصطناعي في سيول، كوريا الجنوبية في 7 يونيو/حزيران 2024-رويترز

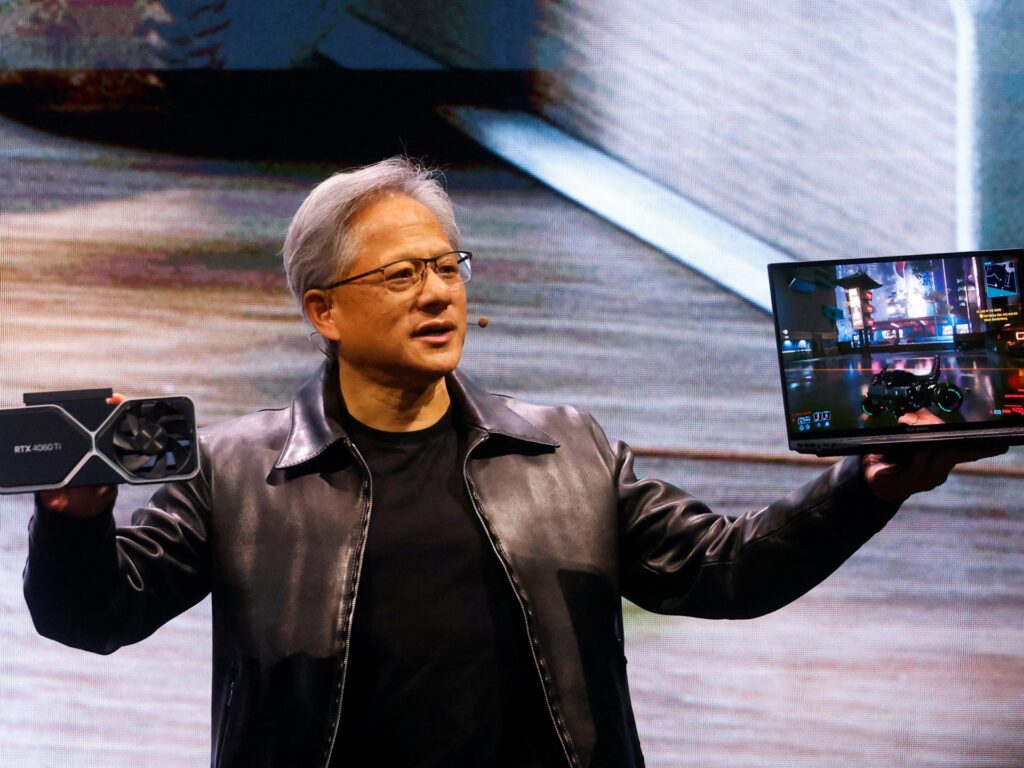

وقد تجلت إمكاناتها بشكل كبير في عام 2009، عندما زاد الباحثون في جامعة ستانفورد الأمريكية من السرعة التي يمكن أن تعمل بها الشبكة العصبية 70 ضعفاً، باستخدام جهاز كمبيوتر للألعاب.

كان هذا ممكناً لأنه بالإضافة إلى “وحدة المعالجة المركزية” (CPU) الموجودة في جميع أجهزة الكمبيوتر، كان لدى هذا الجهاز أيضاً “وحدة معالجة الرسومات” (GPU) لإنشاء عوالم الألعاب على الشاشة. وقد تم تصميم وحدة معالجة الرسومات بطريقة مناسبة لتشغيل كود الشبكة العصبية.

إن اقتران تسريع الأجهزة بخوارزميات تدريب أكثر كفاءة يعني أنه يمكن تدريب الشبكات التي تحتوي على ملايين الاتصالات في وقت معقول؛ يمكن للشبكات العصبية أن تتعامل مع مدخلات أكبر، والأهم من ذلك، أن يتم إعطاؤها المزيد من الطبقات.

وتبين أن هذه الشبكات “الأعمق” أكثر قدرة بكثير.

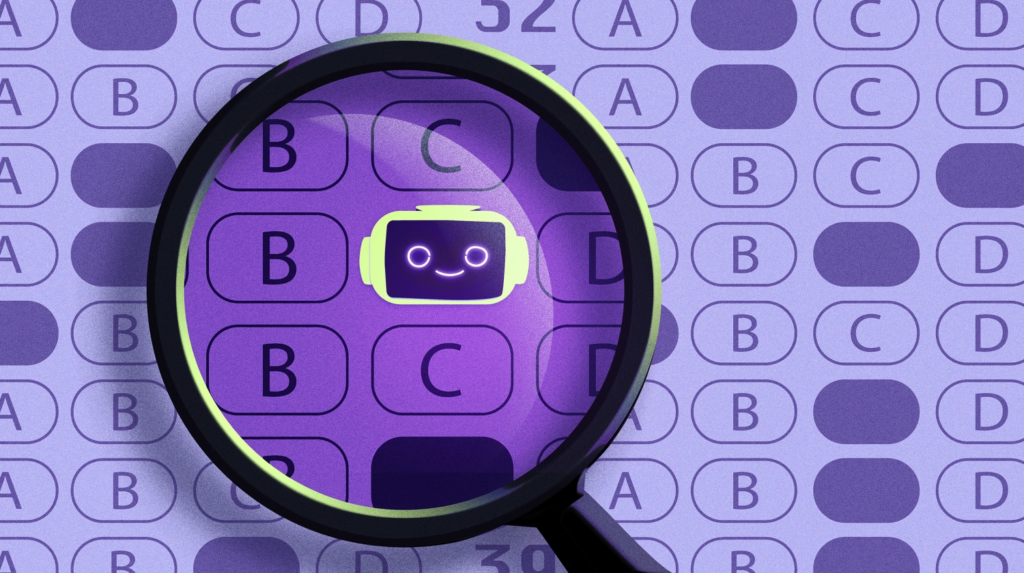

نهج التعلم العميق يثبت تفوقه في مجال التعرف على الصور عن الإنسان

أصبحت قوة هذا النهج الجديد، الذي أصبح يعرف باسم “التعلم العميق”، واضحة في تحدي إيماجنت لعام 2012. وقد تم تزويد أنظمة التعرف على الصور المتنافسة في التحدي بقاعدة بيانات تضم أكثر من مليون ملف صورة مصنفة. بالنسبة لأي كلمة معينة، مثل “كلب” أو “قطة”، كانت قاعدة البيانات تحتوي على عدة مئات من الصور.

ويتم تدريب أنظمة التعرف على الصور، باستخدام هذه الأمثلة، على “ربط” المدخلات، في شكل صور، بالمخرجات في شكل أوصاف مكونة من كلمة واحدة. ثم يتم تعريض الأنظمة لتحدي إنتاج مثل هذه الأوصاف عند تغذية صور اختبارية لم ترها من قبل.

وفي عام 2012، استخدم فريق بقيادة جيف هينتون، الذي كان آنذاك في جامعة تورنتو الكندية، التعلم العميق لتحقيق دقة تصل إلى 85%. تم الاعتراف به على الفور باعتباره اختراقاً.

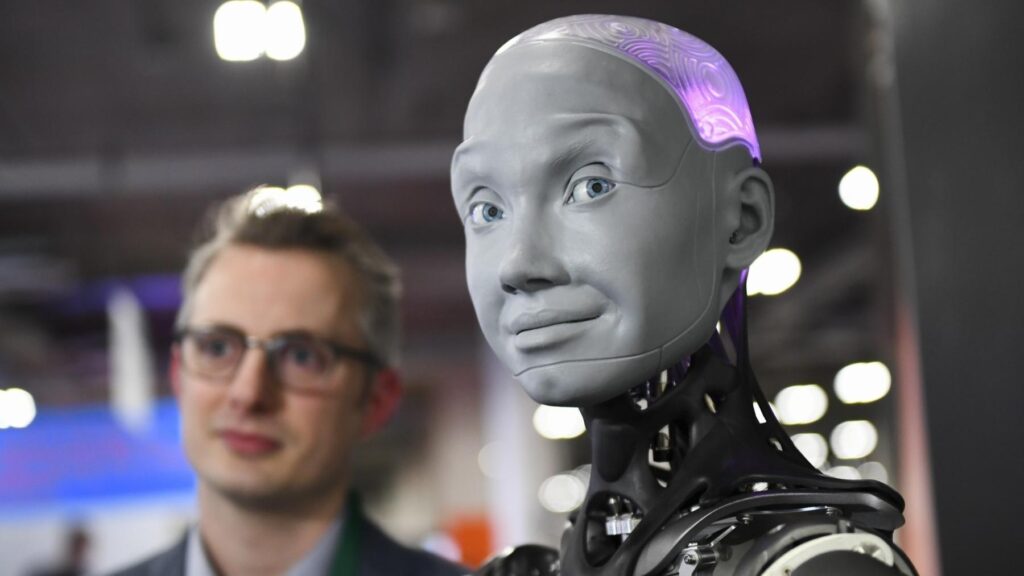

آلة تتكون من ذراع روبوت وحاقن ألوان للشفاه باستخدام تقنية الذكاء الاصطناعي، في سيول عاصمة كوريا الجنوبية في 7 يونيو/حزيران 2024-رويترز

بحلول عام 2015، كان جميع العاملين في مجال التعرف على الصور تقريباً يستخدمون التعلم العميق، ووصلت الدقة الفائزة في تحدي “إيماجنت” إلى 96%، وهي نسبة أفضل من متوسط النتيجة البشرية. تم أيضاً تطبيق التعلم العميق على مجموعة من “المشكلات… المخصصة للبشر” والتي يمكن اختزالها في رسم خرائط لنوع واحد من الأشياء على نوع آخر: التعرف على الكلام (تحويل الصوت إلى نص)، والتعرف على الوجوه (رسم خرائط للوجوه على الأسماء)، والترجمة.

وفي جميع هذه التطبيقات، كانت الكميات الهائلة من البيانات التي يمكن الوصول إليها عبر الإنترنت أمراً حيوياً لتحقيق النجاح؛ علاوة على ذلك، يشير عدد الأشخاص الذين يستخدمون الإنترنت إلى إمكانية وجود أسواق كبيرة. وكلما كانت الشبكات أكبر (أي أعمق) تم إنشاؤها، وكلما زادت بيانات التدريب التي تم تقديمها لها، كلما تحسن أداؤها.

البيانات الضخمة تحدث نقلة في تاريخ الذكاء الاصطناعي

نحن نعيش الآن في عصر “البيانات الضخمة”، وهو العصر الذي نمتلك فيه القدرة على جمع كميات هائلة من المعلومات التي يصعب على الفرد معالجتها.

لقد كان تطبيق الذكاء الاصطناعي في هذا الصدد مثمرًا بالفعل في العديد من الصناعات مثل التكنولوجيا والخدمات المصرفية والتسويق والترفيه. لقد رأينا أنه حتى لو لم تتحسن الخوارزميات كثيراً، فإن البيانات الضخمة والحوسبة الضخمة تسمح للذكاء الاصطناعي بالتعلم من خلال القوة الحوسبية.

وسرعان ما تم نشر التعلم العميق في جميع أنواع المنتجات والخدمات الجديدة. ظهرت الأجهزة التي تعمل بالصوت مثل Alexa من Amazon. أصبحت خدمات النسخ عبر الإنترنت مفيدة. عرضت متصفحات الويب ترجمات تلقائية. إن القول بأن مثل هذه الأشياء تم تمكينها بواسطة الذكاء الاصطناعي يحتاج إلى تدقيق فتقريبًا كل التقنيات التي يشار إليها باسم الذكاء الاصطناعي تعتمد في الواقع على التعلم العميق.

ثورة ChatGPT ومنافسيه تمت عبر تقنية المحولات

في عام 2017، تمت إضافة تغيير نوعي إلى الفوائد الكمية التي توفرها المزيد من القوة الحاسوبية والمزيد من البيانات، وهي طريقة جديدة لترتيب الاتصالات بين الخلايا العصبية تسمى “المحول”.

تعمل المحولات على تمكين الشبكات العصبية من تتبع الأنماط في مدخلاتها، حتى لو كانت عناصر النمط متباعدة، بطريقة تسمح لها بمنح “الانتباه” لميزات معينة في البيانات.

وأعطت المحولات الشبكات فهماً أفضل للسياق، وهو ما جعلها مناسبة لتقنية تسمى “التعلم الخاضع للإشراف الذاتي”.

في هذا النهج يمكن حذف بعض الكلمات عشوائياً أثناء التدريب، ويقوم النموذج بتعليم نفسه لملء الفراغات بالكلمة الأكثر احتمالاً. ونظراً لأنه ليس من الضروري تصنيف بيانات التدريب مسبقاً، فيمكن تدريب مثل هذه النماذج باستخدام مليارات الكلمات من النص الخام المأخوذ من الإنترنت.

بدأت نماذج اللغات الكبيرة القائمة على المحولات (LLMs) في جذب اهتمام أوسع في عام 2019، عندما تم إصدار نموذج يسمى GPT-2 بواسطة OpenAI، وهي شركة أمريكية ناشئة.

وGPT تعني المحولات التوليدية المدربة مسبقاً. وتبين أن مثل هذه النماذج قادرة على إنشاء سلوك لم يتم تدريبها عليه بشكل واضح.

إن استيعاب كميات هائلة من اللغة لم يجعلها ماهرة بشكل مدهش في المهام اللغوية مثل التلخيص أو الترجمة فحسب، بل أيضاً في أشياء – مثل العمليات الحسابية البسيطة وكتابة البرامج – التي كانت مضمنة في بيانات التدريب.

الذكاء الاصطناعي يعيد إنتاج تحيزات المجتمع

ولكن الأمر المثير للقلق في هذه المرحلة من تاريخ الذكاء الاصطناعي هو أن طبيعة الأنظمة الحالية أنها تعيد إنتاج التحيزات في البيانات المقدمة لهم، مما يعني أن العديد من التحيزات السائدة في المجتمع البشري ظهرت في إنتاجهم.

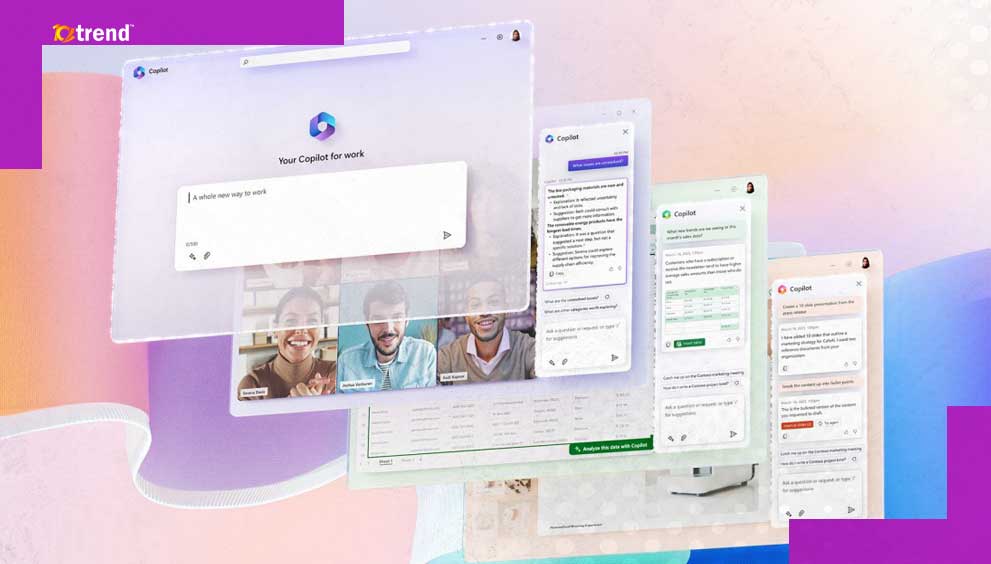

في نوفمبر/تشرين الثاني 2022، تم تقديم نموذج OpenAI أكبر، GPT-3.5، للجمهور في شكل Chatbot. يمكن لأي شخص لديه متصفح ويب إدخال طلب والحصول على رد.

لم ينطلق أي منتج استهلاكي بشكل أسرع منه في أي وقت مضى.

وفي غضون أسابيع، كان ChatGPT ينتج كل شيء بدءاً من المقالات الجامعية وحتى رموز الكمبيوتر.

يقوم ChatGPT والمنافسون، مثل Gemini (من جوجل)، وكلود من Anthropic، الذي أسسه باحثون سابقون في OpenAI بإنتاج مخرجات من الحسابات تماماً كما تفعل أنظمة التعلم العميق الأخرى.

لكن حقيقة أنهم يستجيبون للطلبات بعناصر جديدة تجعلهم مختلفين تماماً عن البرامج التي تتعرف على الوجوه أو تلقي الإملاء أو تترجم القوائم. ويبدو أنهم في الحقيقة “يستخدمون اللغة” و”يشكلون أفكاراً تجريدية”.

ما الذي يحمله لنا الذكاء الاصطناعي في المستقبل؟

في المستقبل القريب، تبدو لغة الذكاء الاصطناعي وكأنها الشيء الكبير التالي، في الواقع، إن تطورها يحدث بالفعل.

ففي هذه الأيام، الآلات يمكن أن تتصل بك! يمكن للمرء أن يتخيل التفاعل مع نظام خبير في محادثة سلسة أو إجراء محادثة بلغتين مختلفتين تتم ترجمتها في الوقت الفعلي.

يمكننا أيضاً أن نتوقع رؤية سيارات ذاتية القيادة على الطريق خلال العشرين عاماً القادمة (وهذا تقدير متحفظ). وعلى المدى الطويل، الهدف هو الذكاء العام، أي آلة تتفوق على القدرات المعرفية للإنسان في جميع المهام. وهذا على غرار الروبوت الواعي الذي اعتدنا على رؤيته في الأفلام.

ويقول روكويل أنيوها طالب دراسات عليا في قسم البيولوجيا الجزيئية في مقاله بموقع جامعة هارفارد “بالنسبة لي، يبدو من غير المتصور أن يتم تحقيق ذلك في الخمسين سنة القادمة. وحتى لو كانت القدرة موجودة، فإن المسائل الأخلاقية ستكون بمثابة حاجز قوي أمام تحقيق هذا الهدف. عندما يحين ذلك الوقت (ولكن من الأفضل حتى قبل أن يحين الوقت)، سنحتاج إلى إجراء محادثة جادة حول سياسة الآلة وأخلاقياتها (ومن المفارقات أن كلاهما موضوعات بشرية بشكل أساسي)، ولكن في الوقت الحالي، سنسمح للذكاء الاصطناعي بالتحسن بشكل مطرد.